Definición de la Generación Aumentada por Recuperación (RAG)

El término «retrieval-augmented-generation» (RAG) se refiere a un enfoque en inteligencia artificial que combina la recuperación de información (retrieval-recuperación) con la generación de texto. El modelo RAG utiliza un mecanismo de búsqueda para recuperar información relevante de una base de datos o corpus y luego genera respuestas o contenido basado en esta información recuperada.

La Generación Aumentada por Recuperación (RAG) implica mejorar la salida de un modelo lingüístico de gran tamaño al hacer referencia a una base de conocimientos verificada, aparte de sus datos de entrenamiento, antes de generar una respuesta. Los modelos de lenguaje de gran tamaño (LLM) son entrenados con vastos conjuntos de datos y utilizan una gran cantidad de parámetros para realizar tareas como responder preguntas, traducir idiomas y completar frases. RAG amplía las ya poderosas capacidades de los LLM a dominios específicos o a la base de conocimientos interna de una organización, sin necesidad de reentrenar el modelo. Esto ofrece una forma rentable de mejorar los resultados de los LLM para que sigan siendo relevantes, precisos y útiles en diversos contextos.

Importancia de la Generación Aumentada por Recuperación:

Los LLM son esenciales en la inteligencia artificial (IA), impulsando chatbots inteligentes y otras aplicaciones de procesamiento del lenguaje natural (NLP). El objetivo es crear bots capaces de responder preguntas de los usuarios en diferentes contextos, haciendo referencia a fuentes de conocimiento autorizadas. Sin embargo, los LLM pueden presentar desafíos como proporcionar información falsa, desactualizada o genérica, lo que puede afectar la confianza del usuario. Aquí es donde entra en juego el RAG, resolviendo estos desafíos al dirigir al LLM para recuperar información relevante de fuentes confiables, proporcionando así respuestas más precisas y confiables.

Beneficios de la Generación Aumentada por Recuperación

La tecnología RAG ofrece varios beneficios a las iniciativas de IA generativa de una organización:

1. Implementación rentable: Facilita la introducción de nuevos datos en los LLM de manera más económica que el reentrenamiento completo del modelo.

2. Información actualizada: Permite mantener la relevancia al proporcionar las últimas investigaciones, estadísticas o noticias a los modelos generativos.

3. Mayor confianza de los usuarios: Permite al LLM presentar información precisa con atribución de fuente, aumentando así la confianza del usuario en la solución de IA.

4. Más control para los desarrolladores: Permite a los desarrolladores adaptar y controlar las fuentes de información del LLM para diferentes requisitos y corregir problemas rápidamente.

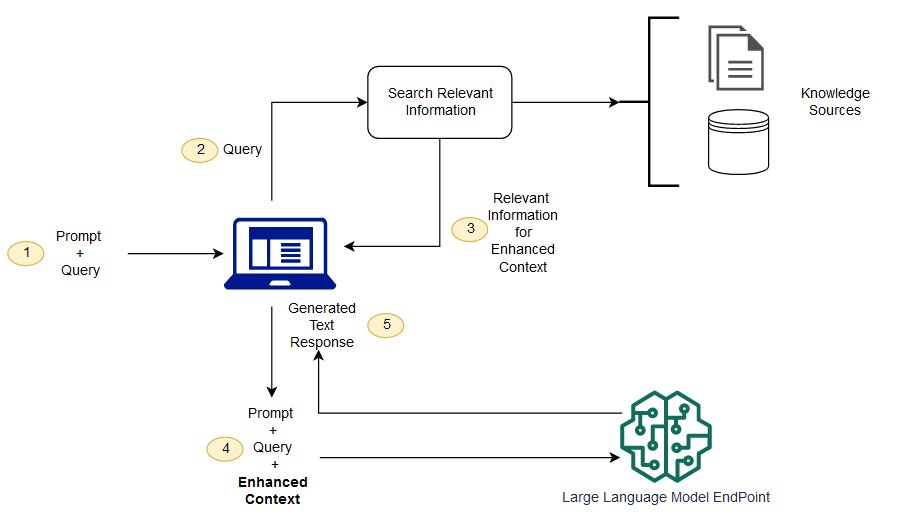

Funcionamiento de la Generación Aumentada por Recuperación

El proceso implica la extracción de información relevante de nuevos datos externos, la adaptación de la entrada del usuario con esta información recuperada y el mantenimiento de la actualización de los datos externos para su recuperación continua. Esto se logra mediante la representación vectorial de consultas y datos, la comparación de relevancia, y la adaptación de la entrada del usuario al LLM con la información recuperada, lo que permite respuestas más precisas y actualizadas.

La diferencia entre la generación aumentada de recuperación y la búsqueda semántica radica en sus enfoques y capacidades

La búsqueda semántica complementa la generación aumentada de recuperación al ofrecer una solución más precisa y eficiente para las organizaciones que buscan integrar amplias fuentes de conocimiento externas en sus aplicaciones de LLM. En un entorno donde las empresas acumulan una gran cantidad de información dispersa, desde manuales hasta informes de investigación y documentos de recursos humanos, la recuperación del contexto puede resultar desafiante a gran escala, lo que afecta la calidad de los resultados generativos.

Las tecnologías de búsqueda semántica tienen la capacidad de explorar vastas bases de datos y recuperar datos con mayor precisión. Por ejemplo, pueden responder preguntas específicas como «¿Cuánto se gastó en reparaciones de maquinaria el año pasado?» al identificar documentos relevantes y extraer información específica en lugar de simplemente proporcionar una lista de resultados de búsqueda. Esto permite a los desarrolladores enriquecer la entrada del LLM con más contexto.

A diferencia de las soluciones convencionales de búsqueda basadas en palabras clave en la generación aumentada de recuperación, que pueden producir resultados limitados y requieren una preparación manual de datos complicada, la búsqueda semántica automatiza este proceso. Las tecnologías de búsqueda semántica se encargan de la preparación de la base de conocimientos, generando pasajes semánticamente relevantes y seleccionando palabras clave ordenadas por relevancia. Esto maximiza la calidad de la información proporcionada al LLM y reduce la carga sobre los desarrolladores.

Escribenos para solicitar información de nuestras soluciones de Inteligencia Artificial